近日,第32届ACM国际多媒体学术会议(ACM International Conference on Multimedia,简称ACM MM)公布论文接收结果,网易伏羲最新研究成果《Selection and Reconstruction of Key Locals: A Novel Specific Domain Image-Text Retrieval Method》入选,该论文研究方向涉及视觉语言预训练(VLP)、跨模态图文检索(CMITR)等领域。此次入选标志着网易伏羲实验室多模态能力再受国际认可,目前相关技术已应用至网易伏羲自研多模态智能体助手“丹青约”。

ACM MM由国际计算机协会(ACM)发起,是多媒体处理、分析与计算领域最具影响力的国际顶级会议,也是中国计算机学会推荐的多媒体领域A类国际学术会议。作为领域内的顶级会议,ACM MM 受到国内外知名厂商和学者广泛关注。本届ACM MM共收到有效稿件4385篇,其中1149篇被大会接收,接收率为26.20%。

作为国内领先的人工智能研究机构,网易伏羲在大规模模型研究领域已有近六年的深厚积累,具备丰富的算法和工程经验,先后打造了数十个文本和多模态预训练模型,包括文本理解和生成大模型,图文理解大模型,图文生成大模型等。这些成果不仅有效推动了大模型在游戏领域的应用,也为跨模态理解能力的发展奠定了坚实的基础。跨模态理解能力有助于更好地融合多种领域知识,并对齐丰富的数据模态及信息。

在此基础上,网易伏羲基于图文理解大模型进一步创新,提出一种基于关键局部信息的选取与重建的跨模态检索方法,为多模态智能体解决特定领域下的图像文本交互问题奠定技术基础。

以下为本次入选论文概要:

《Selection and Reconstruction of Key Locals: A Novel Specific Domain Image-Text Retrieval Method》

关键局部信息的选取与重建:一种新颖的特定领域图文检索方法

关键词:关键局部信息,细粒度,可解释

涉及领域:视觉语言预训练(VLP),跨模态图文检索(CMITR)

近年来,随着视觉语言预训练 (Vision-Language Pretraining, VLP) 模型的兴起,跨模态图像文本检索 (Cross-Modal Image-Text Retrieval, CMITR) 领域取得了显著进展。尽管像 CLIP 这样的 VLP 模型在一般领域的 CMITR 任务中表现出色,但在特定领域图像文本检索 (Specific Domain Image-Text Retrieval, SDITR) 中,其性能往往会存在不足。这是因为特定领域通常具有独特的数据特征,这些特征区别于一般领域。

在特定领域内,图像之间可能展现出高度的视觉相似性,而语义差异则往往集中在关键的局部细节上,例如图像中的特定对象区域或文本中含义丰富的词汇。即使是这些局部片段的细微变化也可能对整个内容产生显著影响,从而凸显了这些关键局部信息的重要性。因此,SDITR 要求模型专注于关键的局部信息片段,以增强图像与文本特征在共享表示空间中的表达,进而改进图像与文本之间的对齐精度。

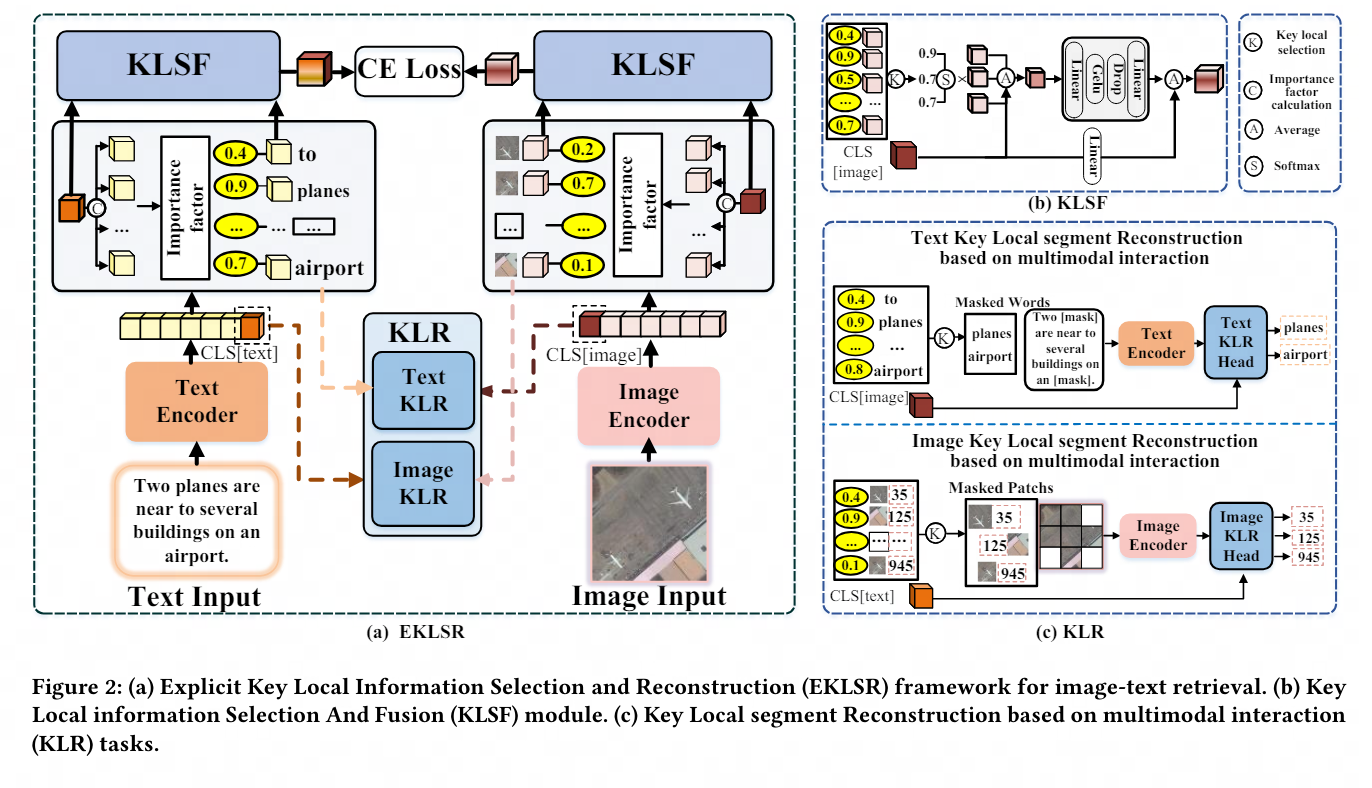

本课题通过探索视觉语言预训练模型在特定领域图像-文本检索任务中的应用,研究了特定领域图像-文本检索任务中的局部特征利用问题。主要贡献在于提出了一种利用具有判别性的细粒度局部信息的方法,优化图像与文本在共享表示空间中的对齐。

为此,我们设计了显式关键局部信息选择和重建框架和基于多模态交互的关键局部段重构策略,这些方法有效地利用了具有判别性的细粒度局部信息,从而显著提升了图像与文本在共享空间中的对齐质量,广泛和充分的实验证明了所提出策略的先进性和有效性。

在此特别感谢西安电子科技大学IPIU实验室对本论文的大力支持与重要研究贡献。

此项研究成果不仅标志着网易伏羲在多模态研究领域再次取得重要突破,也为特定领域的跨模态理解提供了全新的视角和技术支撑。优化图像与文本在特定场景下的交互准确度,这项工作为跨模态理解技术在实际应用场景中的提升奠定了坚实的基础。目前,网易伏羲的多模态理解能力已在网易集团的多个业务部门得到广泛应用,包括网易雷火、网易云音乐、网易元气等。这些应用覆盖了诸如游戏创新性文字捏脸玩法、跨模态资源搜索、个性化内容推荐等多种场景,展现了巨大的业务价值。

未来,随着研究的深入与技术进步,该成果有望促进人工智能技术在教育、医疗、电子商务等多个行业的广泛应用,为用户提供更加个性化和智能化的服务体验。网易伏羲也将持续深化与国内外顶尖学术机构的交流与合作,在更多前沿研究领域展开深入探索,共同推动人工智能技术的发展,为构建一个更高效、更智能的社会贡献力量。

扫描下方二维码,立即体验“丹青约”,享受“更懂你”的图文并茂的多模交互体验!