人工智能之面部与身体动画迁移:重塑虚拟与现实交互的未来

在虚拟现实(VR)、影视制作、游戏开发等领域,如何让数字角色实现自然流畅的表情与动作,一直是技术突破的核心方向。人工智能之面部与身体动画迁移技术通过深度学习与计算机视觉的结合,正在打破传统动画制作的局限,为虚拟角色赋予真实生命。本文将从技术原理、应用场景及挑战等维度,解析这一领域的创新价值。

1、技术原理与核心概念

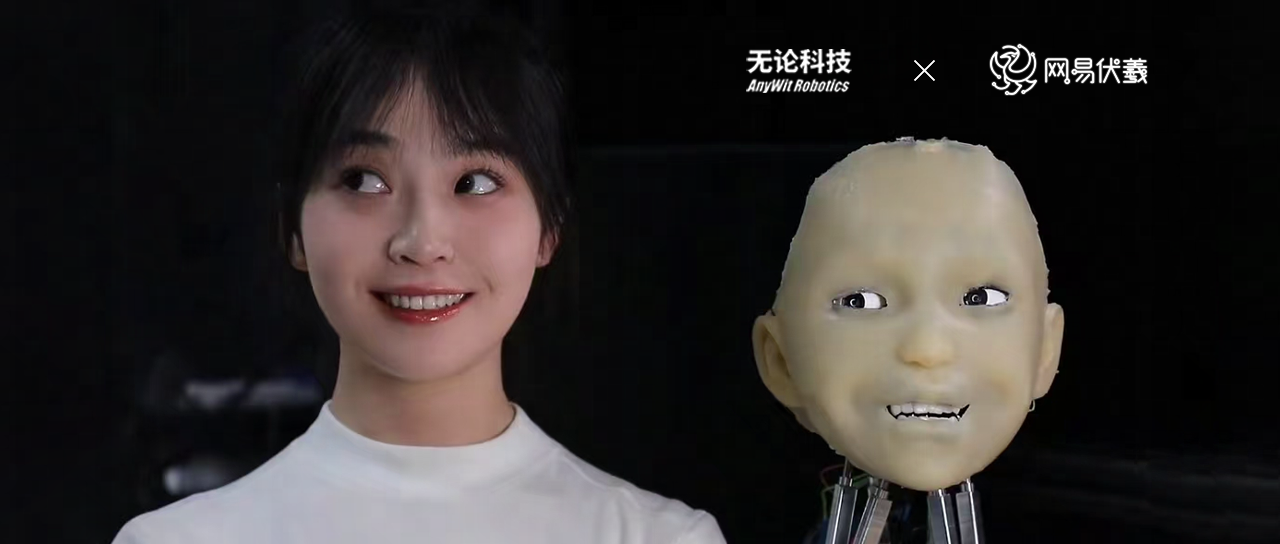

面部与身体动画迁移指通过算法将源对象(如真人演员)的表情、动作等动态特征,精准迁移至目标对象(如虚拟角色或机器人)的过程。其核心技术包括:

面部特征提取:利用卷积神经网络(CNN)识别面部关键点(如眼睛、嘴唇、眉毛),捕捉细微表情变化。

身体运动建模:通过骨骼绑定与运动捕捉技术,将人体关节运动轨迹转化为数字化动作数据。

跨模态数据对齐:解决源数据(如视频、传感器)与目标模型之间的时空差异,确保迁移动作的连贯性。

例如,通过单目摄像头捕捉演员表情,AI可实时驱动虚拟角色的面部肌肉运动,甚至模拟瞳孔收缩、皮肤纹理变化等细节。

2、核心技术突破

面部动画迁移的难点在于高精度与低延迟。当前主流方案包括:

3D形变模型(3DMM):基于人脸三维重建,分解表情为线性组合参数,适配不同虚拟角色。

生成对抗网络(GAN):生成逼真面部细节,解决传统方法中“恐怖谷效应”(即表情僵硬不自然)。

实时渲染优化:通过轻量化神经网络与边缘计算,降低对硬件算力的依赖。

身体动画迁移则需解决复杂环境下的运动适配问题:

运动重定向(Retargeting):将动作从不同体型或骨骼结构的源角色迁移至目标角色,保持动作合理性。

物理引擎融合:结合环境重力、碰撞反馈等物理规则,避免虚拟角色动作穿模或失衡。

3、多领域应用场景

影视与游戏制作:传统动画需逐帧手动调整,耗时数月。AI动画迁移技术可将演员表演直接转化为角色动画,大幅缩短制作周期。例如,电影《阿凡达2》通过高精度面部迁移技术,呈现了水下纳美人的细腻表情。

虚拟偶像与元宇宙:虚拟主播、数字人客服等场景依赖实时动作迁移,AI技术可让虚拟角色与用户自然互动,提升沉浸感。

医疗与教育:通过模拟患者表情或手术动作,辅助医生培训;在教育领域,历史人物或科学实验可通过动画迁移“复活”,增强学习趣味性。

4、技术挑战与未来趋势

尽管潜力巨大,动画迁移技术仍面临多重挑战:

数据稀缺性:高精度动作需大量标注数据,而小众场景(如特殊表情、极限动作)数据采集困难。

跨物种迁移:将人类动作迁移至非人形角色(如动物、机器人)时,需解决生物力学差异问题。

伦理与隐私:深度伪造(Deepfake)技术滥用风险需通过数字水印、内容溯源等手段防范。

未来发展方向包括:

无标记迁移:仅凭普通摄像头或单张图片即可生成高保真动画,降低设备门槛。

情感增强迁移:结合心理学模型,让AI不仅复制动作,还能自主生成符合角色性格的情感表达。

多模态融合:整合语音、手势、环境感知数据,打造全息交互体验。

5、总结

人工智能之面部与身体动画迁移正在重构数字内容的生产方式,从影视工业到日常生活,其应用边界不断拓展。随着算法迭代与硬件升级,未来虚拟角色的表情与动作将无限逼近真实人类,为人机交互、娱乐体验乃至社会服务开辟全新可能。这一技术的成熟,不仅是AI能力的体现,更是人类创造力与科技融合的里程碑。